在深度学习领域,卷积神经网络(CNN)和长短时记忆网络(LSTM)已经成为解决复杂问题的两大核心算法。无论是在图像分类、语音识别,还是在自然语言处理(NLP)等领域,CNN和LSTM都展示了其卓越的性能。要充分发挥这些模型的优势,正确的训练流程至关重要。今天,我们将详细探讨CNN和LSTM模型的训练流程,并为大家提供一份高效的流程图模板,帮助大家更清晰地理解和实现这些算法。

卷积神经网络(CNN)是一种擅长图像处理的深度学习算法,它通过模拟生物视觉皮层的工作原理,利用卷积操作提取图像中的特征。CNN广泛应用于图像识别、物体检测、自动驾驶等领域。

CNN的训练流程主要包括数据预处理、模型设计、训练过程和评估阶段。数据预处理是训练的第一步。为了提高模型的训练效率,我们需要对图像数据进行归一化、标准化,并进行数据增强操作(如旋转、缩放、裁剪等),以避免过拟合并提高模型的泛化能力。

接着是模型设计。CNN的基本结构包括卷积层、池化层、全连接层和输出层。在设计模型时,我们需要根据具体任务选择合适的层数和神经元数量,并根据问题的性质选择激活函数。常见的激活函数有ReLU、Sigmoid、Tanh等,其中ReLU因其计算简单且效果好,常常成为默认选择。

在训练过程中,我们使用反向传播算法和梯度下降法来优化模型的参数。通过不断调整卷积核的权重和偏置,CNN能够逐步减少预测误差,从而提高模型的准确性。训练过程中,还需要合理选择批大小(batchsize)、学习率(learningrate)等超参数,这些参数直接影响训练的收敛速度和模型的效果。

模型训练完成后,我们需要进行评估。常用的评估指标包括准确率、召回率、F1分数等。在评估过程中,我们不仅要关注训练集上的表现,还需要检验模型在验证集和测试集上的表现,以防止过拟合。

与CNN不同,长短时记忆网络(LSTM)主要用于处理时序数据,尤其适用于自然语言处理、语音识别和时间序列预测等任务。LSTM的最大优势在于它能够有效解决传统RNN(循环神经网络)在长时间序列中出现的梯度消失问题,从而实现对长时序数据的准确建模。

LSTM的训练流程与CNN的流程有很多相似之处,同样包含数据预处理、模型设计、训练过程和评估阶段。LSTM在数据预处理和模型设计上有其独特之处。对于时序数据,我们首先需要对数据进行清洗、标准化处理,并且需要通过滑动窗口等方法,将长时间序列切分为适合模型输入的小数据块,以便于后续训练。

LSTM的核心结构由输入门、遗忘门和输出门组成,这些门控机制能够有效地保存和遗忘信息,从而使得LSTM在处理长序列时更加稳定和高效。在模型设计时,我们需要根据任务的复杂性选择适当的LSTM单元数量,并设置合适的层数和神经元数目。

在训练过程中,LSTM通过反向传播算法和梯度下降法进行优化。不同于CNN,LSTM通常需要更多的训练时间,因为其网络结构更加复杂。在训练时,选择合适的优化器和学习率尤为重要,常用的优化器有Adam、RMSprop等。

LSTM模型的评估同样依赖于准确率、精确率和召回率等指标。由于LSTM通常用于时序预测任务,往往还需要对预测结果进行进一步的时间序列分析。

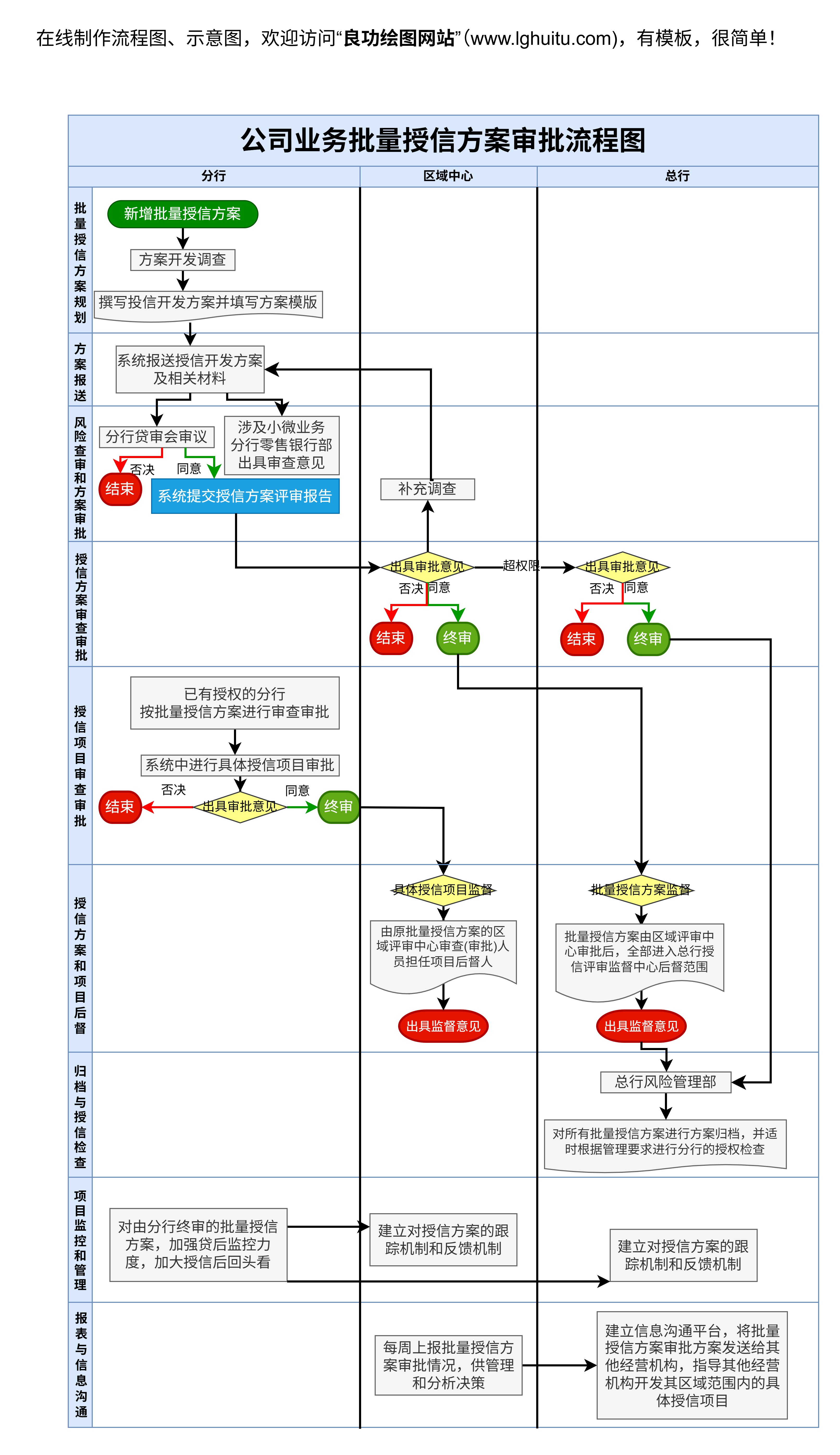

为了帮助大家更加清晰地理解CNN和LSTM的训练流程,我们提供了一份实用的流程图模板,涵盖了从数据预处理到模型评估的全过程。

选择适合的激活函数(例如ReLU、Sigmoid)

通过对CNN和LSTM训练流程的深入分析,结合具体的训练流程图模板,您可以清晰地了解如何高效地训练和评估这两种模型。无论是在图像处理还是时序数据分析中,掌握正确的训练流程都是实现高效模型优化的关键。如果您是数据科学家、开发者或对深度学习有浓厚兴趣的学习者,这篇文章将为您的模型训练提供有力的帮助。

通过这些流程图模板,您不仅能够加深对CNN和LSTM的理解,还能在实际应用中更加轻松地进行模型构建与优化。如果您希望进一步了解模型的详细参数调整或获取更多的学习资源,欢迎与我们进行深入交流!